随着人工智能(AI)技术的飞速发展,越来越多的计算任务开始依赖强大的图形处理单元(GPU),特别是GPU中的显卡。显卡在AI中的作用日益突出,尤其是在深度学习和复杂的数据处理领域。但是,为何AI操作会消耗显卡资源?显卡在AI中的角色是什么?本文将深入探讨这些问题,并为读者提供全面的理解。

显卡在AI中的作用

1.为何AI操作会消耗显卡资源?

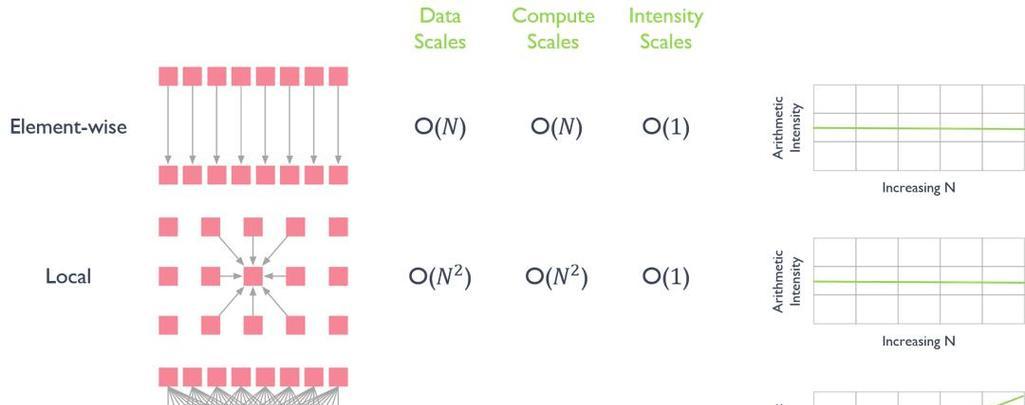

在AI领域,尤其是深度学习中,神经网络的训练和推理过程需要大量的并行计算。显卡拥有数以千计的核心,这使得它能够同时处理成千上万个计算任务,远超传统CPU的多核处理能力。当深度学习模型需要对大量数据集进行迭代训练时,显卡便成为理想的选择。

2.显卡在AI中的角色是什么?

显卡在AI中的角色可以概括为以下几个方面:

高性能计算:AI算法尤其是深度学习模型,需要进行大量的矩阵运算,显卡的GPU架构可以高效地完成这些运算,加速整个训练过程。

数据并行处理:显卡擅长处理并行任务,这在AI模型的训练中至关重要,因为可以同时处理成千上万个数据点。

图形加速:虽然AI操作不直接与图形处理相关,但深度学习中的卷积神经网络(CNN)借鉴了图像处理的技术,因此显卡在这些任务中也表现出了独特的优势。

内存带宽:AI模型在训练过程中需要处理大量数据,这要求有高内存带宽来保证数据能够快速流入GPU进行计算。

深度学习中的显卡应用

1.显卡与深度学习框架

深度学习框架如TensorFlow、PyTorch等都支持GPU加速。这些框架内置了对显卡友好的计算图,可以优化算法在GPU上的运行效率。这意味着在使用这些框架时,只需简单配置,就能实现模型训练的GPU加速。

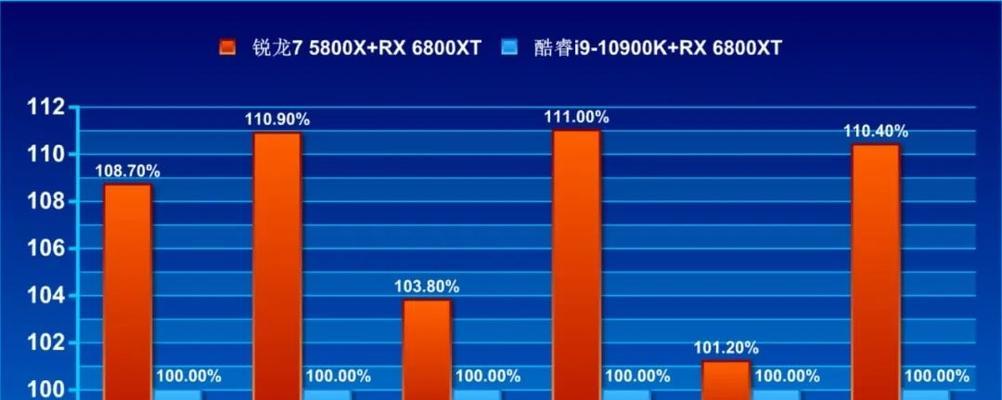

2.显卡与模型训练效率

使用显卡进行模型训练,可以大幅减少模型训练所需的时间。对于大型网络和复杂任务,显卡提供的加速效果尤为明显。比如,一个在CPU上可能需要几天的训练过程,在GPU上可能只需要几个小时。

显卡选择与配置

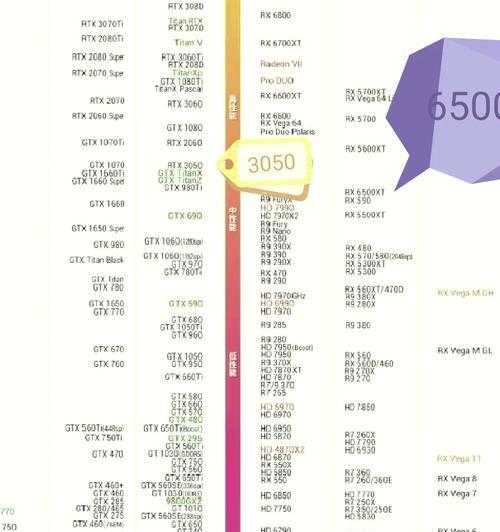

1.如何选择合适的显卡?

在选择用于AI的显卡时,需要考虑以下因素:

计算能力:核心数和每秒浮点运算次数(FLOPS)是衡量显卡计算能力的重要指标。

内存大小:训练大型模型需要更多的显存。

性价比:需要根据自己的预算和项目需求,权衡显卡的性能和价格。

2.显卡配置注意事项

显卡配置时需要关注以下几点:

驱动安装:确保显卡驱动是最新的,以支持最新AI技术的运行。

系统兼容性:显卡需要与操作系统、主板及其他硬件兼容。

散热和电源:高负荷的计算会增加显卡的温度,需要考虑良好的散热解决方案和稳定的电源供应。

常见问题解答

1.AI操作对显卡资源消耗是否过大?

是的,AI操作尤其是深度学习模型的训练对显卡资源的消耗非常大。但随着技术进步,显卡的能效比也在不断提升,使其成为AI领域不可或缺的工具。

2.使用AI时,如何避免显卡资源过载?

可以通过以下方法避免显卡资源过载:

分批训练:将大量数据分批进行训练,避免一次性加载过多数据到显存。

模型优化:优化模型结构,例如减少参数数量或使用轻量级网络结构。

硬件升级:如果频繁出现资源过载,可能需要升级到性能更强的显卡。

结语

综上所述,显卡在AI领域扮演着至关重要的角色,其强大的计算能力和高效的数据处理能力极大地推动了人工智能技术的发展。在选择和配置显卡时,应充分考虑项目的具体需求,并做好相应的准备工作,以确保AI项目的顺利进行。随着AI技术的持续进步,显卡的潜力还有待进一步挖掘,我们期待未来在这一领域会有更多突破性的进展。